چگونه یک Storage Group بسازیم؟

در این آموزش قصد داریم مقداری در خصوص فرآیندهایی که احتمالا روزانه یک مدیر Storage با آن درگیر است صحبت کنم.

درست کردن یک Lun

اولین مرحله از آموزش ما تولید یک LUN است. در این آموزش تمامی مراحل با بهره گیری از GUI انجام می شود ولیکن قابلیت انجام تمامی این مراحل توسط CLI نیز موجود است. بسیار خوب در ابتدا به EMC خود متصل شوید و پس از باز شدن صفحه اولیه Unisphere، تجهیز مورد نظر خود را انتخاب نمایید. پس از آن در منوی بالایی بروی قسمت Storage بروید و آنگاه LUN را انتخاب نمایید.

Unisphere Storage Menu

وقتی که LUN را انتخاب نمودید در صفحه بعد لیستی از تمامی LUN های موجود خود را مشاهده می نمایید. شما می توانید نحوه نمایش این لیست را به سلیقه و دلخواه خود تغییر دهید و یا حتی این لیست را بصورت یک فایل Export نمایید. از دکمه های پایین صفحه گزینه “ Create “ را انتخاب نمایید.

Unisphere – LUN Section

بعد از انتخاب دکمه ” Create ” پنجره زیر را می بینید :

Create New LUN https://infofurmanner.de/

قطعا چیزی که شما بروی تجهیز خود مشاهده می نمایید با تصویر فوق یکسان نیست. بنا به تنظیمات شما تفاوتهایی وجود دارد. در تصویر نمونه ما یک Pool با Raid 6 بنام Pool-Bronze داریم.

موارد ابتدایی که باید آنها را وارد نمایید و همچنین به خوبی درک نمایید عبارتند از :

- آیا شما یک Pool LUN می خواهید و یا یک Raid Group LUN ؟

- آیا LUN شما باید Thin باشد یا Thick ؟ آیا باید Deduplication روی آن فعال باشد یا خیر ؟

- ظرفیت آن چقدر باید باشد و LUN ID آن چند باید باشد ؟

در این مثال، ما قصد داریم یک Pool LUN با سایز ۱۰۰ GB تولید کنیم.برای این منظور من از یک Storage Pool که از قبل ساخته شده است و Pool-Silver نام دارد، استفاده می کنم. من می خواهم این LUN بصورت Thin باشد. همچنین قصد دارم LUN ID شماره ۴۳۰۲۳ را برای آن انتخاب کنم.

Create New LUN

بعد از کلیک بروی گزینه “ Apply “ ، یک تاییدیه از شما گرفته می شود و آنگاه LUN تولید می شود و در نهایت یک پیغام ” Success ” دریافت می کنید.

همین! تمام شد! شما توانستید یک LUN بسازید. به همین سادگی!

اتصال به یک HOST

در اولین قدم ما یک LUN ساختیم. حال ما به یک Host برای اتصال و دسترسی به LUN نیاز داریم. در این مثال می خواهیم نحوه ساخت یک Host را فرا بگیریم. فرض کنید یک Host جدید در محیط ما به تازگی نصب و راه اندازی شده است ولیکن تا کنون روشن نشده است. اما ما از HBA WWN آن مطلع هستیم.

تا زمانی که سرور روشن نشده است، ما هیچ Host را در لیست Host List نخواهیم دید. در شرایط عادی پس از اتصال Host به Storage، عموما توسط یک Host Agent و یا Unsiphere Server Utility و در موارد خاصی هم بصورت دستی، Host خود را بروی تجهیز Register می نماید. Host Agent ها در دو نسخه ویندوزی و لینوکسی موجود هستند و با نصب آنها بروی سرور مربوطه فرآیند Auto Register اتفاق می افتد. لازم بذکر است که با توجه به اینکه vMware از شرکتهای زیر مجموعه EMC است، تمامی Hypervisor های این شرکت بصورت پیش فرض این Agent را در خود دارند.

در این مثال ما قصد داریم شیوه Manual Registration را انجام دهیم. برای این منظور به منوی Host رفته و آنگاه Initiators را انتخاب نمایید.

Unisphere Host Menu

تمامی هاستهای متصل به SAN حداقل یک Initiator در این لیست دارند. شما باید بتوانید صفحه شبیه تصویر زیر ببینید :

Unisphere – Initiators

بسیار خوب، چیزی که می بینید لیستی است از تمامی Initiator های موجود. یک قانون مهم : هر Initiator می تواند تنها در یک Storage Group باشد. هیچ استثنایی نیز ندارد. این قانون در واقع می گوید که : هر هاست تنها و تنها می تواند در یک Storage Group وجود داشته باشد. حال اگر با دقت بیشترب به تصویر ارائه شده نگاه کنید، درمی یابید که هر هاست می تواند بیش از یک Initiator نیز داشته باشد. پس می توان با شیوه ای خاص یک هاست را در چندین Storage Group قرار داد!

حال ببینیم چگونه می توان بین یک هاست و یک LUN توسط Storage Group ارتباط برقرار کرد.

در صورت رعایت اصول MPIO هر هاست دارای ۴ Initiator خواهد بود.

- host_HBA_1 connected to Port_X in Storage Processor A

- host_HBA_1 connected to Port_Y in Storage Processor B

- host_HBA_2 connected to Port_Z in Storage Processor A

- host_HBA_2 connected to Port_U in Storage Processor B

در این شیوهما هیچ Single Point Of Failure برای قطع ارتباط مابین هاست و Storage نداریم. از آنجاییکه نمی خواهم این آموزش پیچیده و غیر قابل درک شود و برای اینکه این مثال ساده تر پیش برود، فرض می کنیم که هاست ما دارای تنها یک Initiator است که به پورت ۵ ،SP A متصل است. در پایین صفحه شما می توانید دکمه Register را بیابید.

Create Initiator Record

بسیار خوب پس از انتخاب Register، در پنجره جدید WWN را وارد نمایید. پورت متصل به هاست را تعیین کنید و Failover Mode را در حالت Active-Active یا همان ALUA بگذارید و برای نام test_host و برای آن IP آدرس را وارد نمایید، آنگاه بروی دکمه OK بفشارید.

Create Initiator Record

موفقیت آمیز بود و توانستیم یک هاست جدید تولید نماییم. حال پس از Refresh نمودن باید بتوانید هاست جدید را در لیست ببینید.

Unisphere – Our “fresh” Initiator

همانگونه که می بینید هاست جدید عضوی از Storage Group بنام management~ می باشد. management~ در واقع یک Storage Group خاص است. و هر هاستی که در آن حضور دارد بدین معناست که آن هاست درون هیچ Storage Group واقعی نیست.

بسیار خوب وارد Host List شوید. اسم هاست جدید را می توانید در اینجا ببینید:

Unisphere Host List

همانگونه که دریافتید ما هاست را بصورت دستی تولید کردیم. اکنون ما هاست خود را برای اضافه کردن به Storage Group در اختیار داریم.

تولید یک Storage Group

اگر هنوز نمی دانید که Storage Group چیست و چرا به آن نیاز داریم می توانید آموزش ” معرفی Access Logix، LUN Masking و Storage Groups ” را مطالعه نمایید.

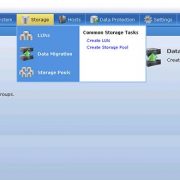

برای درست کردن یک Storage Group خیلی ساده به قسمت Host > Storage Group بروید و آنگاه بروی گزینه Create کلیک نمایید و تنها نیاز است که برای آن یک نام تعیین کنید:

Create Storage Group

من یک Storage Group با نام new_SG درست کردم. پس از کلیک بروی گزینه OK یک سوال از شما پرسیده می شود مبتنی بر اینکه : آیا شما مطمئنید که …. ؟؟؟!!! قطعا. من که مطمئنم!! شما را نمی دونم!!

پس از آن شما شما یک پنجره شبیه این می بینید :

New Storage Group

همانگونه که می بینید فرآیند تولید موفقیت آمیز بوده و گزینه ” Yes, I want to add LUNs and/or connect host ” را انتخاب نمایید. این صفحه را خواهید دید :

Adding LUNs to Storage Group

در ابتدا شما باید گزینه (ADD LUN(s را انتخاب نمایید. LUN های تولید شده خود را بیابید و آنگاه گزینه “ Add “ را بفشارید.

یک موضوع مهم در اینجا، انتخاب Host LUN ID است. همانگونه که دید من برای این منظور هیچ مقداری وارد نکردم و Storage بصورت خودکار یک Host LUN ID را به هاست اعطا کرد. در صورت نیاز جهت آشنایی بیشتر با HLU/ALU می توانید به آموزش ” معرفی Access Logix، LUN Masking و Storage Groups ” مراجعه نمایید.

پس از انتخاب LUN مورد نظر بروی کلید “ Apply “ بفشارید و آنگاه Tab بعدی یعنی Host را انتخاب نمایید:

Connect Host to Storage Group

تنها کار که نیاز است در اینجا انجام دهید انتخاب هاست و یا هاستهای دلخواه است. در پایان گزینه OK را بفشارید.

خلاصه

شاید در ابتدا کمی پیچیده بنظر برسد ولیکن تنها نیاز است که در انجام تمامی این فرآیندها دقت عمل داشته باشید. در نهایت این مسائل را نیز بیاد داشته باشید :

- شما می توانید چند LUN را به تعدادی Storage Group اضافه نمایید، تنها لازم است که گزینه “ Show LUNs” را به “Already Connected To Different Storage Group “ تغییر دهید.

- بصورت پیش فرض شما می توانید یک هاست را تنها در یک Storage Group قرار دهید و اگر هاستی را در Storage Group دومی قرار دهید، آنگاه آن هاست از عضویت Storage Group اول خارج می شود.

- عضویت یک هاست در Storage Group بنام managment~ بمعنای عدم عضویت آن هاست در یک Storage Group واقعی است.